(报告出品方/作者:川财证券,孙灿)

一、 数字经济、AI、智能驾驶视角下看算力需求

1.1 演变趋势:从通用计算到智能计算,从分散独立到云网边协同

宏观角度下,数字经济建设及人工智能发展掀起了新一代算力革命,算力基建成为国家 数字化转型和经济发展的重要竞争策略。从 1964 年戈登·摩尔提出著名的摩尔定律后, CPU 性能的发展便遵循这一规律,但目前数字经济与人工智能的高速发展,基于 CPU 的摩尔定律已经失效,如何突破“算力墙”,满足新时代各种算力需求,成为各国主要 的竞争焦点。

微观角度下,算力形式逐渐由通用计算过渡为高性能计算,从分散独立的端计算向云网 边协同计算演变。当前,常见的高性能计算可以分为科学、工程计算与智能计算;算力 资源服务可以分为云计算、混合计算及算力网络。 1)科学、工程计算。这类计算主要利用超级计算机实现并行计算,是一种算法优化和 硬件集群结合的计算模式。高性能计算由于具有较高的性能、效率及计算精度,可以广 泛的用于大规模复杂科学计算,比如工程模拟仿真、航空航天、地震预测等,同时也能 支持人工智能、智慧城市等新兴领域。 2)智能计算。智能计算以智能芯片为计算算力底座,可以较好的满足 AI 领域模型训练 所需的智能运算需求,因此用于支持专一的人工智能应用场景。基于智能计算搭建的人 工智能计算中心,通过将各种交叉技术集成,广泛的应用于智能语音处理、机器视觉、 自然语言(文本)处理等不用的领域。 3)云计算、混合计算、算力网络属于新型算力资源服务模式。云计算通过 World Wide Web(万维网)向用户提供包括服务器、存储、数据库等在内的各项计算服务,因为万维网以网页为核心,因此云计算主要面向消费互联网;而算力网络主要以算法及算力协 同为核心,通过协同联动云计算、边缘计算、端计算及通信网络,能够实现对复杂计算 任务的分解及高效调度。

1.2 战略地位:算力属于基础设施建设,是智能时代发展的物理承载

整体架构层面,算法、算力及数据是实现人工智能的三要素,其中算力是构筑智能时 代的物理基础。人工智能离不开算力、算法及数据,其发展需要在建立在庞大的数据 集、优秀的深度学习算法及强大的计算能力基础之上,而算力作为底层基础设施,是 开启智能时代的关键因素,其核心于智能芯片的技术进步。

实际发展层面,全球数据量正以指数级速度增长,“算力荒”问题日益凸显。据 IDC 数据 显示,2018 年至 2019 年全球大数据存储量分别为 33Z B、41 ZB,而 2020 年全球数据 量达到了 60 ZB,同比增长 46%;庞大的数据集必然依赖强大的数据处理能力,进而要 求宏观算力快速发展,NTCysd 预计 2021-2028 年全球算力规模将以超过 40%的速度增 长,2028 年将达到 7510 EFlops。

1.3 应用驱动:数字经济搭建整体框架,AI 大模型、智能驾驶持续拉升

市场方面,数字经济建设、AI 大模型、智能驾驶成为开启智能时代的确定性研究方向。 其中,数字经济建设搭建数字化布局整体框架,并提供政策支持;AI 大模型及智能驾驶 率先落地,成为拉动算力需求的核心驱动力。

1)全球正加快数字经济建设,算力发展成为主要战略竞争点之一。目前,全球正处于 经济数字化转型阶段,据中国信通院发布的《全球数字经济白皮书》显示,数字经济已 经成为各国发展 GDP 的核心战略,具体数据来看,2020 年全球 47 个国家数字经济增 加值达到 32.6 万亿美元,占 GDP 比重为 43.7%,同比名义增长 3%。此外,数字经济 已经成为我国稳增长促转型的重要引擎,出台多项政策支持算力发展,截至 2022 年我 国数字经济规模已达 50.2 亿元,数字基础设施规模能级大幅提升,在用数据中心算例 总规模超 180 EFlops,位居世界第二。

2)AI 大模型的快速扩张是算力需求的关键驱动力。由于 AI 大模型通常需要在大规模 无标注的数据集上进行重复的训练,因此相比于传统的小模型在应用场景上更具有普 适性。但与此同时,数据集的快速增长以及模型不断迭代优化使得 AI 大模型尺寸快速 膨胀,GPU 算力也遵循着同样的增长规律。据 OpenAI 数据显示,GPT-3 175B 相比 于 GPT-3 Small,总计算力(Flops)及参数量增长了约 1400 倍;而据 Semianalysis 最新分析指出,GPT-4 模型尺寸进一步扩张,在其 120 层模型中总共包含了 1.8 万亿参 数,约 GPT-3 175B 参数量的 10 倍。

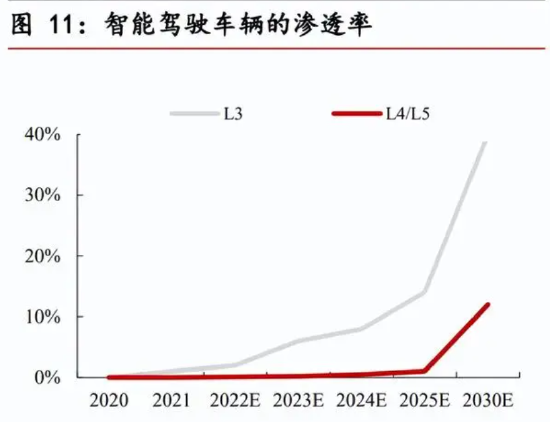

3)汽车智能化功能升级,智能驾驶将贡献算力需求的全新增量。汽车正逐渐步入智能 化时代,传感器数量的增加及交互能力的提升,将带来数据的几何式增长,这必然要求 车端拥有强大的数据分析和处理能力。据华经产业研究院预测,2025 年我国 L3、L5 级别智能驾驶渗透率将分别达到 14%、1%,到 2030 年两者将分别达到 40%、12%。而 L3 级别及以上智能驾驶汽车,不仅需要处理人机交互等指令,还需要与外界环境、云数 据中心进行交互。据分析,L3、L5 级别智能驾驶算力需求将分别达到 30-60 TOPS、 100T OPS,未来随着智能驾驶汽车渗透率的提升,将会持续带动智能驾驶市场整体算 力需求的增加,预计 2025、2030 年智能驾驶市场算力需求达到 1.9 万、19 万 TOPS, 2021-2025 CAGR 达 112%。

1.4 优化路径:提升芯片性能及创新存算架构是研究主流

系统算力主要受处理器性能与数据传输能力影响,当数据处理能力与传输能力不匹配时,计算能力由两者中较低者决定。处理性能主要与指令复杂程度、频率、并行度有 关,一般来说,指令越复杂、计算频率越高、并行程度越大,处理器性能就越好;而 数据传输的能力与处理器内部存算架构有关,在计算机体系里,根据访问延迟及容量 大小将存储结构分为寄存器、缓存、内存、外存与远程存储,而这种存算分离的架构 形式,通常使得数据传输成为限制系统算力的因素。

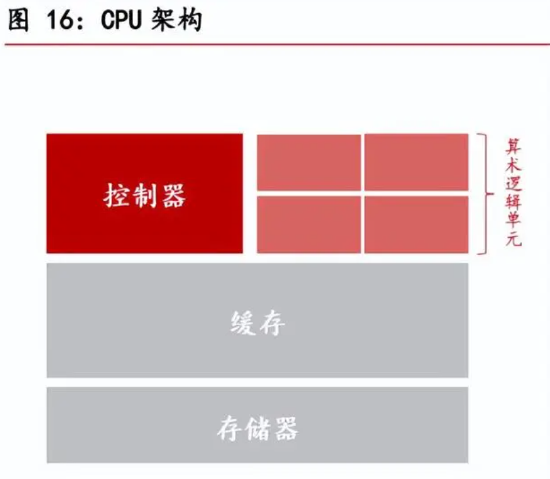

1)指令的复杂程度。指令系统是连接计算机软件和硬件的桥梁,一般来说,指令的复 杂程度于处理器运算性能有关,指令越复杂,其性能就越好。典型的处理器平台大致可 以分为 CPU、协处理器、GPU、FPGA、DSA、ASIC,其中 CPU 为通用软件平台,支 持包括整形计算类、浮点类、数据传输类、控制类等在内的通用指令,而其余处理器为 硬件加速平台,用于执行各类复杂指令。

2)计算频率。一般来说,处理器计算的速度于频率呈现正相关关系,计算频率越高,速 度越快。以 CPU 为例,执行一条指令需要依次经过取址、译码、地址生成、取操作数、 执行、写回阶段,每个阶段需要消耗一个时钟周期,上个阶段执行完毕后才会进入到下 个阶段。在此基础上,时钟周期的设定便取决于各阶段用时最大者,而提高时钟频率大 致有两种方法:一是通过超流水线架构提高处理器主频,通过增加多级流水从而细化每 个阶段;一是通过优化工艺技术降低各阶段逻辑门处理延迟。

3)并行度。并行度是指在计算机体系中,指令并行执行的最大数目,并行度越大,意味 着系统能够同时处理更多指令,其运算速度越快。常用的并行设计包括指令并行、处理 器核并行、芯片级并行及服务器并行。

4)数据传输能力。数据传输能力并不直接影响处理器性能,但复杂的存储分层结构会 使得系统功耗、延迟及访问宽带增加,从而限制算力的提升。优秀的计算系统应使得处 理器性能与数据传输能力尽可能匹配,以减少“木桶效应”对于算力的限制。目前,数 据传输能力的优化方向主要包括近存计算及存算一体化架构。

二、 算力需求视角下看GPU发展的必然趋势

2.1 性能:GPU 技术发展迅速,高并发计算能力契合算力需求

1)横向比较,GPU 较 CPU 而言,更符合深度学习算法的高度并行计算需求。 一方面,CPU 性能提升已达到瓶颈,与高速增长的算力需求脱节。CPU 作为第一代高 效计算平台,目前无论从不管是从架构/微架构设计、工艺、多核并行等各种角度出发, 其性能都难以提升,2016 年之后,CPU 性能每年提升仅 3.5%。随着数字经济、AI 大 模型、智能驾驶等算力需求的推动,CPU 性能已无法满足上层软件算力需求。

另一方面,GPU 较 CPU 具备更多的算术逻辑单元、控制单元与内存缓存,其 SIMD 架 构与深度学习算法需求更吻合。CPU 为线程级并行的 MIMD 架构,其核心少但性能强,可以用来处理复杂的控制逻辑、预测分支、乱序执行、多级流水等,而 GPU 为数据级 并行的 SIMD 架构,其核心多但性能弱,用于优化具有简单控制逻辑的数据并行任务。 而神经网络算法数据要求量大,并行计算程度高,与 GPU 高并行计算能力、高内存带 宽相适配。神经网络的训练环节需要处理大量的数据,并且其结构非常统一,每一层成 千上万个相同的人工神经元都在执行相同的计算操作,具有高效并行计算能力与内存带 宽的 GPU,不仅能够更快的完成数据的读取与写入,还能实行多条指令并行计算。

2)纵向比较,GPU 架构技术仍在演进,其高性能计算与智能计算能力不断优化

GPU 最早作为显卡的核心零部件,专用于图形渲染及处理。GPU(Graphic Processing Unit),即图形处理单元,英伟达公司在 1999 年发布 GeForce 256 图形处理芯片时首 先提出 GPU 的概念,GeForce 256 作为专门负责计算机图形显示的计算机零部件,通 过 T&L 及其他多项技术引擎,减少了显卡对于 CPU 的依赖。GPU 组成中通常包含一 个显存、一个主频、一个 VRAM、一个显存速率以及一个显存位宽。

GPU 架构迭代频繁,已从从专用图形处理器发展为高效的通用计算平台,向外拓展人 工智能计算及高性能计算领域。当 GPU 引入可编程特性,将图形硬件的流水线作为流 处理器来解释,基于 GPU 的通用计算也开始出现,即 GPGPU。 英伟达产品在 2008-2022 年内,架构迭代调整了 8 次,其在 2010 年推出具有完整 GPU 架构的 Fermi,在 2017 年 Volta 架构中首次推出 Tensor 内核以支持深度学习算法,而 目前 Hopper 架构的 GPU 已广泛的应用于 AI 大模型训练与推理环节。

英伟达 Tensor 核心持续升级,智能计算及高性能计算能力得到不断优化,已成为 AI 模 型推理的关键张量核心。英伟达 Tensor 核心最初在 Volta 架构上推出,在后续推出的 Turing、Ampere、Hopper 上不断优化,Tensor 核心能够加速矩阵运算,大幅增加浮点 计算吞吐量。具体来看,拥有 Tensor 核心的 V100 相比于 P100 其混合精度运算速度提 高了 9 倍,而英伟达推出的第四代 Tensor 核心其 FP8 性能较 Ampere FP6 提高 16 倍, 而在 AI 大型语言模型推理方面,性能比 Ampere 高出 30 倍。

2.2 灵活性:GPU 可编程优势明显,通用灵活性适配 AI 应用端拓展

GPU 拥有相对较优的性能及灵活性。常用的计算平台包括 CPU、FPGA、GPU、DSA 以及 ASIC,一般情况下随着芯片性能的提升,其灵活性会逐渐下降。CPU 为软件加速 平台,通过标准化的指令集使得 CPU 平台的硬件实现与软件编程完全解耦,灵活性最 高;ASIC 为专用集成电路,是一种为专门目的而设计的集成电路,不支持硬件编程, 灵活性最差。

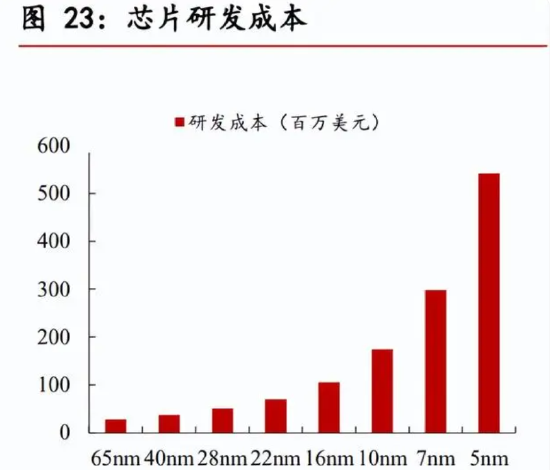

1)ASIC、DSA 设计成本高、周期长,其灵活性难以满足应用层及宏架构趋势的需求。 DSA 与 ASIC 属于专用领域定制类型芯片,其中 ASIC 属于完全定制性化芯片,其晶体 管根据算法定制,流片量产后算法便不可编辑;DSA 在 ASIC 基础上回调,保留一定编 程能力,但其功能覆盖的领域成具有较大的局限性。ASIC 与 DSA 的通用性是限制其应 用的关键因素。 首先,通用性限制了 ASIC 与 DSA 的应用领域,与芯片高企的研发成本相矛盾。据估 计,5nm 制程的芯片研发成本已经超 5 亿美元,高企的研发成本需要具有充分量产能力 芯片来摊薄,而 ASIC 与 DSA 芯片均为面向特定领域芯片,不同领域则面临重新 设计的问题,尤其是在 AI 应用领域,ASIC 与 DSA 的研发周期和成本并不能满足其 AI 应用及算法迭代优化的速度。

其次,专用性使得 ASIC 与 DSA 芯片与算力融合的宏架构趋势相矛盾。数字经济的建 设需用云、网、边各部分资源协同融合,从而组成庞大的算力网络,然而不同计算引擎、 平台、设备以及数据中心的芯片应用场景具有较大的差异,这使得 DSA、ASIC 芯片难 以成为数字经济时代的整体解决方案。

2)CUDA、OpenCL 技术持续为 GPU 赋能,GPU 性能提升潜力大、应用拓展力强。 一方面,CUDA 生态为 GPU 提供各种数据接口(API)、算法库与工具、跨平台支持以 及大规模集群计算支持,CUDA 使得开发人员能够使用流行的编程语言对英伟达 GPU 进行编程,同时还集成包括 TensorFlow、PyTorch 和 MXNet 在内的所有深度学习框架; 另一方面,随着深度学习算法和模型的收敛,GPU 可以通过对算法进行手工优化实现 资源的高效调度,充分释放出硬件的性能,每一代 CUDA 升级都会带来约 10-20%的性 能提升。

三、 GPU市场:供给推动市场,技术及产能是核心驱动力

3.1 需求端:移动端兜底,自动驾驶及数据中心建设贡献增量

GPU 下游目前主要应用于移动端、数据中心服务器以及车规级芯片。其中,移动端应 用又可以分为 PC GPU、手机 GPU,主要用于加速图形处理,以提高计算机游戏的图 像质量及性能,目前随着深度学习及人工智能的发展,移动端 GPU 也可以用于加速深 度学习、计算机视觉和自然语言处理等人工智能应用;数据中心服务器又可以分为高 性能计算服务器与智能计算服务器,由于 GPU 具有高并发的计算能力,因此被广泛的 用于数据中心建设;在汽车领域,GPU 主要应用于车端及其配套设施智能芯片,负责 处理来自摄像头、普通雷达、激光雷达等传感器数据,实现智能驾驶。

1)个人电脑为 GPU 移动端主要市场,智能手机及可穿戴设备有望渗透。GPU 作为图 形处理加速硬件,其最常见的应用即为个人电脑、智能手机等游戏设备,不限于创建图 像、图像处理、计算摄影、手势识别的视觉处理需求。但目前随着消费电子需求减弱, 尤其是个人电脑市场下滑的影响,PC 端显卡需求处于下行区间,据 Jon Peddie Research 数据统计,2023 年第一季度全球 PC 桌面显卡销量约 630 万块,同比下降 52.9%。

手机游戏图显需求及终端 AI 架构,有望打造移动端 GPU 增长新引擎。一方面,手机端 游戏市场规模逐渐增大,NEWZOO 数据显示,2022 年全球移动游戏市场规模已达 1035 亿美元,约占游戏市场总规模 53%;另一方面,手机端 GPU 光线追踪技术尚未普及, 未来随着手机端游戏图形渲染需求的提升,对 GPU 性能要求将逐渐增加,目前高通、 联发科、英伟达、AMD、ARM 等著名芯片厂商均开始布局手机 GPU,有望加速移动端 GPU 扩量。

移动端作为 AI 架构的终端设备,有望承载部分 AI 计算功能。随着 AI 技术的快速发展, 以及计算需求的提升,AI 处理须分布在云端及终端进行,这种混合 AI 架构可以根据模 型和查询需求的复杂度等因素,选择不同方式在云端和终端侧之间分配处理负载。未来, 随着终端侧 AI 处理需求的提升,将对终端设备,包括手机、电脑、汽车、XR 等便携设 备以及物联网设备的 AI 计算及推理性能提出新的需求,有望带动移动端 GPU 需求的提 升。

2)自动驾驶贡献 GPU 全新增量,蓝海广阔。车载芯片的架构模式经历分布式架构向混 合式架构转变,未来将向中心计算架构演进。计算架构将随着自动驾驶升级进行优化, 不同的计算架构,对于车载芯片的要求具有差异。分布式架构计算需求小,仅通过 CPU 控制;混合式架构为实现部分自动驾驶功能将引入 GPU 来辅助计算;而中央计算架构 中,汽车端计算将升级为更加通用的计算平台,进而保证了整车架构的稳定性和功能的 扩展性。

分布式计算架构中,每个 ECU 负责特定的功能如灯光控制、门控制、车轮控制等等, 随着汽车功能的增多,分布式架构需要配置更多的 ECU 及线束,将会使得汽车内部架 构复杂,不利于汽车架构及功能扩展。 混合式计算架构减少了 ECU 数量,根据汽车各部分功能进行划分,如博世将汽车控制 分五个功能域(动力域、底盘域、车身域、座舱域、自动驾驶域),每个功能域设置域 控制器,再通过以太网和 CANFD 相连。不同功能域所需算力不同,座舱域及自动驾驶 域由于要满足人机交互、机器视觉等需求,其算力要求较高,通常通过 DPU (CPU+GPU+FPGA)架构来满足算力需求。 中央计算架构或汽车云计算架构,将功能域深度融合,升级为更加通用的计算平台,将 显著增加车端的计算需求。在这种架构中,区域控制器平台相当于局部中央计算平台, 与混合式架构区域控制器的不同在于,中央计算架构中的区域控制器需要独自处理局部 区域传感器、执行器、ECU 等部件传回的数据,而混合式架构中的区域控制器需将这部 分数据传输至中央计算平台处理;同时还需承担控制和协调本区域执行单元及网络协议 转换的责任。

国内外厂商车载芯片多数采用含 GPU 架构,随着智能驾驶升级,有望拉升车端 GPU 需 求。智能驾驶时代,车端芯片承载的功能增加,不仅需要处理各环节传感器收集的环境 数据、地图定位数据、V2X 信息通信数据,还需要通过各种智能算法规划最佳决策,同 时控制执行单元。随着 AI 技术的进步,基于深度学习算法的智能驾驶方案成为汽车制 造商的布局重点。目前国内芯片制造厂商普遍采用 GPU 加速深度学习算法,例如英伟 达 ORIN 采用 CPU+GPU+ACCEL 架构,其算力由 GPU 及 DLA 提供。根据测算,预 计 2023 年全球自动驾驶领域 GPU 市场空间将达到 24 亿美元。

3)受益于数字经济及人工智能,数据中心市场 GPU 加速放量。高性能计算中心及智算 中心建设属于数字经济建设重要的一环,二者的建设将带动 GPU 市场增长。据 Hyperion 研究显示,2025 年全球高性能计算市场规模将达到 199 亿美元,2022-2025 年 CAGR 约为 5.5%,此外,根据超算 top500 统计,全球前 500 超级计算机中 56%算力由 GPU 提供,GPU 需求将随着高性能计算市场增长同步提升,预计 2023 年全球高性能计算中 心 GUP 市场空间约为 21 亿美元。

不同于高性能计算中心,智算中心是利是用先进的人工智能算法和芯片进行智能算法模 型训练和推理。总量方面,根据 IDC 及中商情报网数据预测,2023 年全球 AI 服务器市 场规模将达到 211 亿美元,同比增长 15%,而据 Aletheia Capital 最新报告分析,2025 年 AI 服务器市场规模将激增至 1350 亿美元,2023-2025 CAGR 高达 152%;价值方 面,由于智能算法具有计算难度小、计算量大等特点,对于计算任务的高并发能力及吞 吐量要求较高,因此对于 GPU 的需求更大,据统计,机器学习型 AI 服务器中,GPU 成 本占比约为 72.8%。未来,随着智算中心建设有序推进,GPU 有望迎来量价齐升,预 计 2023 年 AI 服务器领域 GUP 市场空间约为 187.8 亿美元。

3.2 供给端:英伟达独占鳌头,国内技术追赶空间广阔

英伟达市场份额独占鳌头,国际呈现三强格局,国内厂商加速布局。英伟达凭借技术及 产能优势,在移动端、AI 服务器、自动驾驶领域具有较大话语权。国际市场方面,根据 Jon Peddie Research 调查数据显示,2023 年第一季度,全球桌面级显卡销量约为 630 万块,其中英伟达显卡销量约为 529 万张,以 84%的市场份额占据领先地位,此外销 量位居前三的 GUP 供应商还包括 AMD 及 Intel,其销量分别为 76 万张、25 万张;国 内市场方面,我国厂商 GPU 市场份额较小,正处于技术追赶及国产替代环节,目前国 产 GPU 在数据中心、人工智能以及通用计算型 GPU 领域均实现产品布局,未来随着 国内数据中心、智能驾驶及终端侧 GPU 市场需求的提升,国产 GPU 市场份额有望实现渗透。

1)游戏市场。产品及技术方面,GeForce 是英伟达游戏业务的核心产品,增强技术协 同打造游戏生态圈。英伟达在游戏显卡入门级到专业级领域布局广泛,目前 GeForce 系 列游戏已成为全球最大的游戏平台,拥有超过 2 亿的游戏玩家,其最新产品 GeForce RTX 40 系列,采用新型 SM 多单元流处理器及第四代 Tensor Core,可以通过 AI 增强 图形渲染,多项技术业界领先。

国内的桌面级显卡的主要研究厂商包括芯动科技、摩尔线程以及凌久电子,部分产品已 对标国际中高端产品。其中,芯动科技先后推出“风华 1 号”、“风华 2 号”GPU,其产品支持包括智能座舱、桌面办公、笔记本、服务器等应用在内的各个领域以及 Linux、 Windows、Android 等系统;而摩尔线程首款桌面级游戏显卡 MTT S80,在 1.8GHz 的 主频下,能够提供 14.4TFLOPS 的单精度浮点算力,根据 PassMark 的测试结果,MTT S80 显卡的性能已达到英伟达中端显卡 GeForce GTX 750 Ti 的性能水平。

盈利能力方面,英伟达 2024 财年第二季度游戏业务实现营收 24.9 亿美元,同比增长 22%。疫情期间由于 PC 出货量的下滑,对于公司游戏业务影响较大,2023 财年英伟达 游戏业务实现营收 22.4 亿美元,同比下滑 38%,随着疫情影响退出,游戏业务迎来回 暖。权威机构 Jon Peddie Research GPU 市场统计数据显示,2023 第二季度英伟达以 68%的 PC 显卡市场份额占据市场第一。

2)数据中心市场。英伟达凭借 GUP 硬件实力以及数据中心强大产品矩阵,占据市场领 导地位。GPU 硬件产品方面,英伟达高性能计算 GPU 经历数十代产品迭代升级,其技 术指标全面升级,公司于 2022 年发行的 H100 芯片,采用台积电 4N 工艺,集成最高 可达 18432 个单精度和 9216 个双精度的 CUDA 核心以及 576 个第四代 Tensor 核心, 为高性能计算及 AI 研究提供强大的支持,在算力上,H100 的 FP16、TF32 以及 FP64 性能达到了其上一代产品 A100 的 3 倍,分别为 2000 TFLOPS、1000 TFLOPS 和 60 TFLOPS。

此外,英伟达还在软件及技术产品方面提供支持,通过其丰富的产品矩阵搭建数据中 心一站式解决方案。未来,随着 AI 及高性能计算市场计算需求的不断增长,GPU 之 间以及数据中心之间的通信传输需求也在增加,而英伟达 NVLink 技术可为 GPU 系统 配置高更的宽带及增强的可扩展能力,NVLink Switch 系统基于 NVLink 的高级通信能 力构建,可为计算密集型工作负载提供更高带宽和更低延迟,从而显著增强服务器内 及服务器之间 GPU 通信能力。

国产厂商在高性能计算 GPU 布局者较多,产品性能逐渐向英伟达靠拢。以英伟达最新 发布的数据中心 GPU 为参考,H100 SXM 采用台积电 4N 工艺,其单精度浮点算力已 达到 67 TFLOPS,整型算力已达到 3958 TOPS,相比英伟达前序产品 A100,H100 的 AI 推理性能及 HPC 性能分别提升 30 倍与 7 倍;而目前国内算力较高的产品为壁仞科 技推出的 BR100P,采用台积电 7nm 工艺,峰值状态下单精度浮点算力达 240 TFLOPS, 整型算力达 1920 TOPS,BR100 芯片性能相比于英伟达 A100 性能提升 3 倍以上,向 H100 产品靠拢。

盈利能力及产能方面,数据中心业务营收已超游戏业务,成为英伟达最高收入来源,但 其产能受限于台积电工艺,短期供需缺口较大。据英伟达 2024 财年 Q2 报告,其数据 中心营收已达到 103.2 亿美元,同比增长 171%,约占总营收比例为 76%;产能方面, 英伟达 H100 均由台积电代工,其产能受到台积电工艺限制,据英伟达预计,H100 芯 片 2023 年全年全球范围出货量约为 55 万颗,但据 GPU Utils 数据统计,保守估计情况 下,H100 的供给缺口将达到 43 万颗。壁仞科技 BR100P 系列芯片同样由台积电代工, 预计于 2023 年量产,若量产计划顺利推进,国产替代有望渗透。

3)智能驾驶。 产品及技术方面,英伟达 Thor 芯片领先市场,同时搭建完整的自动驾驶生态网络。英 伟达于 2022 年 9 月宣布其车规级超级芯片 Thor,Thor 基于英伟达最新 CPU 与 GPU 打造,可提供每秒 2000 万亿次浮点运算性能,相比于前序产品 Orin,性能提升 8 倍。 此外,英伟达围绕自动驾驶搭建完整的合作网络与生态,通过包括自动驾驶汽车、卡车、 出租车、Tier1 供应商、仿真测试、传感器、软件、地图在内的合作网络,以及从原始数 据采集到验证的自动驾驶技术、数据中心硬件、软件及工作流在内的生态环境,全方位加固自动驾驶领域护城河。

目前,国内大多数智能驾驶车型选用英伟达产品,地平线与华为自研市场份额正在逐 步扩大。国内蔚来、小鹏、理想等造车新势力车型普遍选用英伟达 ORIN 产品,比 如,在理想的入门级车型中搭载的智能驾驶芯片为地平线征程 5,而在其高配置 Max 车型中则搭载英伟达 ORIN 芯片,除此之外华为在自动驾驶领域同样具有布局,华为 提供自动驾驶的全栈解决方案,其发布的昇腾 610、MDC810 已经量产,MDC610 平 台,单组算力为 200TOPS,与英伟达 ORIN 产品差距较小。

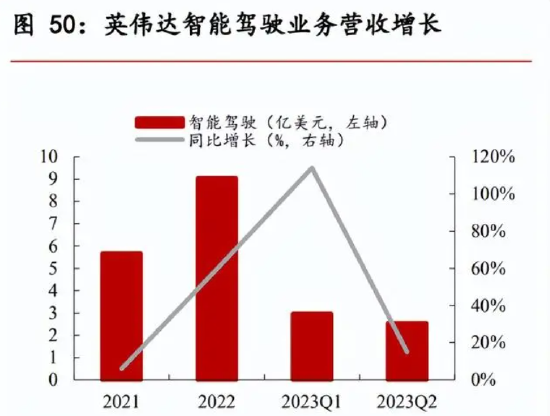

盈利能力及产能方面,英伟达智能驾驶业务 2024 财年 2 季度营收较一季度出现下 滑,但同比增加 15%,总营收达 2.53 亿美元。市场结构上,2023 年度 H1 中国市场 乘用车自动驾驶计算方案市场份额中,英伟达仍以 52.57%的份额占据第一,地平线以 30.71%的市场份额占据第二,华为海思则占据 4.05%的市场份额。

3.3 GPU 产业链概况及国内重点公司介绍

GPU 产业链上中下游分别为芯片设计、芯片制造及芯片封装与测试。产业链上游,GPU 设计基本以英伟达、超微半导体、英特尔三强垄断,中下游台积电凭借先进的 4nm、7nm 工艺及 CoWoS 封装技术产能领先,三星电子、格罗方德半导体、英特尔产能落后,且 在产品工艺上与台积电相比优势不大,此外,在封装测试环节,国内厂商长电科技、通 富微电及赛微电子等具有布局。2022 年全球前十大封测企业中,长电科技以 10.7%的 市场份额位居第三,通富微电以 6.5%的市场份额位居第四。

国内在 GPU 具有布局的公司基本处于产业链上游。重点公司中,景嘉微、凌久电子、 中微电等少数企业拥有完全自主知识产权,从 GPU IP 核、计算架构、算法模型、原 理验证、硬件实现、驱动开发等环节正向设计,从而保证 GPU 升级迭代自主可控;其 他厂商则通过 IP 授权与自主研发相结合的方式开发产品,部分产品在性能上已与国际 接轨。

景嘉微:立足军工显控领域,顺势切入民用领域。公司成立于 2006 年,产品主要涉及 图形显控领域、小型专用化雷达领域及芯片领域。公司是国内为数不多开发出具有完全 自主知识产权 GPU 产品的上市企业,并且在 JM5400 GPU 的基础上,不断研发更为先 进且适用更为广泛的产品,产品布局从机载领域向其他领域延申。 公司通过增发布局通用计算 GPU 市场,有望受益民用市场需求扩量。公司 7 月发布定 向增发说明书,募集资金将用于高性能通用 GPU 芯片研发项目,未来随着车载、船舶 显控、通用市场显控需求的提升,公司未来有望实现军用与民用双向扩容。

受军品下游需求走弱拖累,公司业绩短期承压,二季度已环比改善。公司 2018 至 2022 年营收维持正向增长,2021 年共实现营业总收入 10.93 亿元,同比增加 67%,达到业 绩增速新高,2023 年上半年受军用显控市场走弱影响,短期承压,二季度营收已环比 改善,上半年实现总营收 3.45 亿元,同比减少 37%。未来,随着民用市场 AI 服务器及 自动驾驶市场需求扩量,有望打造公司第二增长曲线。

海光信息:公司产品研发进展顺利,备战服务器广阔市场。公司目前经营的主要产品为 CPU 及 DCU,其中 DCU 即海光协处理器为公司面向大数据处理、人工智能、商业计 算推出的 GPGPU 产品,DCU 系列产品深算一号为公司 GPGPU 主要在售产品,其他 产品中,深算二号发布已提上日程,深算三号研发进展顺利。 公司产品国内领先,已适配主要 AI 大模型。公司 DCU 产品目前已经能够支持大模型训 练,实现 LLaMa、GPT、Bloom、ChatGLM、悟道、紫东太初等为代表的大模型的全面 应用,与国内包括文心一言等大模型全面适配,达到国内领先水平,随着信创领域回暖 及 AI 应用落地,公司业绩有望保持高增长。2018 至 2022 年,公司营收保持高速增长, 2018 至 2022 CAGR 达 221%,2023 年上半年,公司营收增速回落,最终实现营收 26.12 亿元,同增 3%,归母净利维持高增速,最终实现 6.77 亿元,同增 42%。

来源:未来智库

0